本文来自爱范儿

我:今晚去吃顿好的。

Eva:等等我看下哪家评分好。

这是我和朋友 Eva 的日常对话之一,天辰注册登录Eva 是某点评网站的 KOL,她很爱写食评,哪怕喝杯奶茶都能写个 300 字的评论。

我常对她说‘你不来写评测真是可惜了。’

但久而久之,Eva 也变得十分依赖点评网站,吃饭前看评分、看电影看评分、谈游戏三句不离 IGN…… 我常常因为要等 Eva 选出合适的餐厅,而饥肠忍耐十几分钟。

实际上,像 Eva 这种用评分来看产品的人在我身边不是少数。朋友 A 不久前就因 DxOMark 给新 iPhone 的拍照评分过低,直呼他们有失公允。

互联网消费时代,评分决定好坏

评分总能在我们毫无想法时候挖掘出新事物、提供建议,吃饭有点评、电影有豆瓣、手机性能安兔兔、拍照有 DxOMark…… 但出人意料的结果也总让这些平台饱受争议。

毕竟一千个读者就有一千个哈姆雷特,你说这个手机拍照厉害,可按照别人的标准,可能就不是一回事了。

我在某咖啡店点了这杯‘藤椒咖啡’,知道的人不多,所以几乎没有评分,但我觉得它无论是卖相还是味道都挺有意思。

说起‘看评分来辨好坏’,其实我也曾经有过这个经历,只不过当时我主要是看电影评分,天辰注册登录好评多的就去电影院,没有好评的就省下一张电影票。可能由于那时还没有今天那么多点评平台,所以我也没有像 Eva 那么讲究。

要说评分平台的兴起,实际上也就过去三四年才出现的事,这里其中除了因为移动网络逐步发达以外,还有生活内容丰富、手上的硬件越来越先进等因素所在。

作为一名几乎每时每刻都在关注互联网的‘原住民’,我发现曾经含蓄的网友变得越来越有分享精神,吃饭、看电影、去旅游都能评个分。

这要是放在过去的 2G、3G 时代,都是无法想象的事。

然而随着网上的点评内容越来越多,我们也渐渐有了做消费决策前去看评分的习惯:高分的自然优先,低分绝不会在考虑范围。这也无形促进了一种新的消费习惯和一门产业链诞生——用评分来决定产品好坏,用水军来控制评分和评价。

争议不断的‘标准’与‘非标准’评分

这些分数是怎么得出来的?

从个人总结看,当下网络平台的评分方法主要有两种:一种是根据既定的测试标准去对产品进行测试,另一种是结合官方自有标准和大众评价得出结果。

以我最熟悉的智能手机为例,我们熟知的安兔兔、DxOMark 都是根据一个既定标准得出测试成绩的平台,这些平台通常具有以下几种特征:

有一套成熟的测试项目:

被广泛使用

有一定权威性

具有平台主观性

这四个特征可以说是相互紧密关联的。比如前段时间因 iPhone 11 Pro Max 测试而被推上热搜 DxOMark,就是标准化测试的其中一个代表。

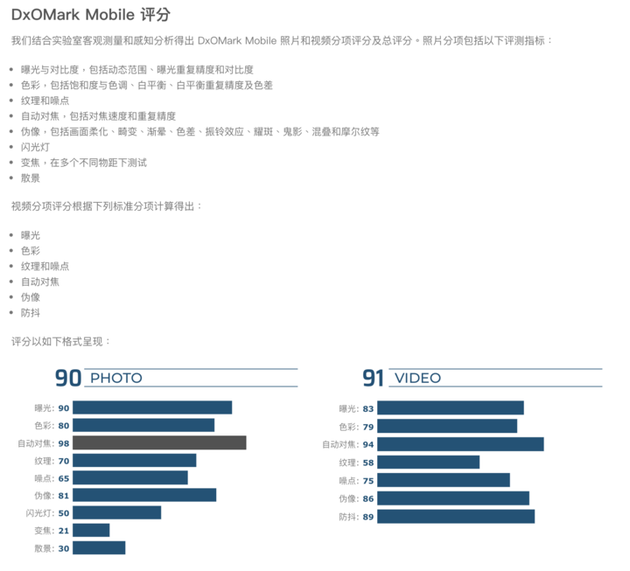

这个机构拥有一套自己的测试项目,其中包括对手机相机的功能、成像质量进行流程化和场景化测试。

2017 年版 DxOMark 相机测试项目。 图片来自:DxOMark

2017 年版 DxOMark 相机测试项目。 图片来自:DxOMark更细化地看,单‘成像质量’一个项目,就包含了相机的曝光、色彩、变焦、降噪、拍照画质、视频画质十多个环节。在执行一套测试后,DxOMark 会根据产品表现打出综合分,分数越高也就代表手机拍照实力越强。

有着大量且严谨的测试,DxOMark 自然也就成了手机拍照的‘标杆指南’,长期稳居排名头部的厂商更时常把 DxOMark 的评分给产品背书,将分数作为相机实力的证明。

不过无论是 DxOMark 还是其他评分平台,通过固定流程去测试产品,也会测出出人意料的结果和争议。

譬如最近拿到 DxOMark 头部排名的小米 CC9 Pro 和华为 Mate 30 Pro,虽然两款手机都是 121 的综合得分(华为拍照单项高 2 分、小米视频单项高 2 分),但在榜单中小米却只排在华为之下。

更让公众对 DxOMark 公平性和客观性产生质疑的是 iPhone 11 Pro Max 的成绩。这同时也让 iMore、Androidauthority 等科技媒体提出质疑和不满——眼看上去差不多,甚至在某些环节中表现还更好,怎么得分就差这么多呢?

许多人可能会在潜意识中认为,DxOMark 应该是一家绝对权威、公平、客观的测试机构,但负责运营 DxOMark 的 DxOMark Image Labs 实际上是一家兼顾解决方案销售、咨询的公司。

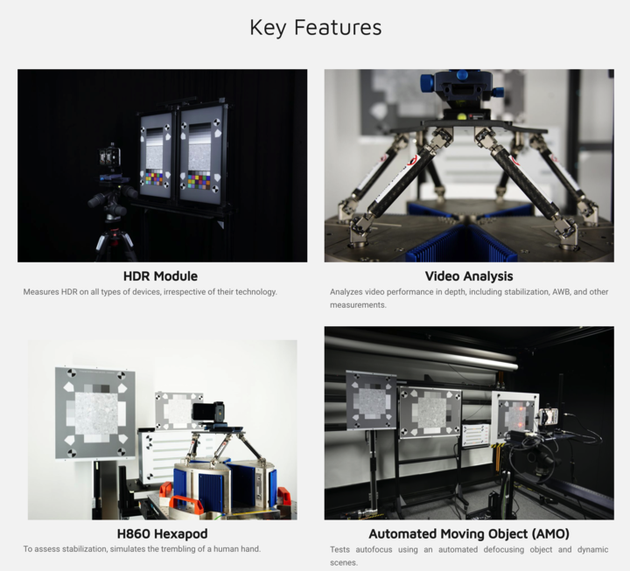

测试相机并得出评分,其实是他们其中一项工作,让 DxOMark Image Labs 实现盈利的是这套测试标准和解决方案。

DxOMark 所售的图像分析仪

DxOMark 所售的图像分析仪换言之,厂商可以通过付费根据标准、购买 DxO 的设备去调校相机,使相机拍照效果更好,或者直接送测跟其他产品 PK 实力。也就是说,DxOMark 的测试就是一次考试,你可以付费上考前冲刺班,其他厂商直接上考场。

所以归根到底,DxOMark 的争议在于他们一只把可能调校过的成绩和未调校过的成绩放在一起对比,又没有做专门备注;二是这个榜单又刚好是 DxOMark 首页最受关注的焦点。

当然,通过标准化流程测试或者盈利也不是不行,毕竟测试的人力、时间、器材测试成本都跟钱画上等号。

有一个既评分也推销,但是很少有争议的例子是 iFixit,他们虽然是卖拆机配件和工具来盈利,但他们不是像 DxOMark 那样向厂商出售某种测试标准和做排名,所以几乎没有出现太大争议。

图片来自:iFixit

图片来自:iFixit‘非标准’评分的定义并不意味着评分没有公信力,而是相比于前面的标准模式,‘非标准’的评分规则除了平台本身既定标准外,还会结合用户的参与数据,客观性更强一点:

参考指标为较多

参考指标每家不同

大众评价影响最终得分

IGN 给《死亡搁浅》仅打出了 6.8 分,但 IGN 的评分也遭到了大众质疑

IGN 给《死亡搁浅》仅打出了 6.8 分,但 IGN 的评分也遭到了大众质疑前段时间上线的《死亡搁浅》评分就是个褒贬鲜明的评分例子。主角 Sam‘快递员’的设定,让 IGN 北美的编辑直接打出 6.8 的低分(评分项目包括:画面、音效、玩法、吸引力和编辑评价等)。

但跟 IGN 同样备受关注的 Gamespot 却给出了 9 分的高分评价 (传闻评分机制比 IGN 更严格),而且之后玩家评论也呈现出两边倒的趋势——一边说受不了冗长的剧情和设定,一边说需要耐心游玩才会体验到其中乐趣。

那《死亡搁浅》到底是不是个好游戏?可能只有仔细品味的玩家才是最有发言权了。

除了游戏平台,影视娱乐也有豆瓣、格瓦拉、猫眼、IMDb 和烂番茄,这些影视评分平台除了自有的一套评分规则,还会依据电影观众的购票量、评论内容、数量等条件给电影打出综合分。

图片来自:《同一部电影,为啥豆瓣、格瓦拉、IMDb 评分差距这么大?》

图片来自:《同一部电影,为啥豆瓣、格瓦拉、IMDb 评分差距这么大?》不过由于每家平台的标准不同,所以这些平台也经常出现一部传世好片‘A 平台有 9 分,B 平台只有 5 分’或‘一部烂片也能被水军刷成 9 分优秀,一部好片被踩成低分’的巨大分差。这也是因为平台和平台之间的评分依据不同,造成部分‘非标准’评分分数差距大的情况。

对此,我们也曾对豆瓣和猫眼两个平台的评分规则、方式进行过深入探讨,这里我也不再累述。我还是回到这篇文章的主题——为何要理智对待评分。

理智看待评分,别让它成为消费的主决策

弄清楚标准和非标准评分两种体系以后,我们大致能知道,无论是哪种标准机制,其实都无法避免主观成分。只是因为标准评分没有群众参与,主观成分相对更多一点而已。

举个例子,DxOMark 虽然是个全球知名的测试网站,也有许多大厂、媒体为其背书,但这套标准本身就存有机构自己的主观性,它并不代表大众用户的最终体验,只是机构的一套测试方法,最终目的是实现解决方案的销售盈利。

另外,将调校方案提供给部分付费厂商,这一点也存在着机构自身的主观性。尽管 DxOMark 曾表示不会因厂商付费而影响排名,但提供调校方案必然会改变产品原来的水准,自然也会把产品排名拔高到另一个水准。

要是考前都把题目做过了,最后考试还是不及格,那这个厂商就该罚了。

说到这里,DxOMark 到底要背上缺乏公信力的锅吗?我觉得也不能这么说,虽然 DxOMark 确实不应该把设备排名混在一起,但机构本身的测试项目和水平都至少处于同行一哥的位置,测试结果还是有着较高的可参考价值。

再退一步讲,向厂商提供调校方案再测试的做法,一方面除了在媒体面前有个好成绩以外,另一方面也是想通过这个平台提供的建议去优化自家产品。

尽管从大众角度看来,厂商更看重的可能是排名,但我们也不得不承认头部排名的产品确实有排在前头的实力。

究其根本,每一家机构都有自己的一套评分体系,而这套体系本身就存在平台自己的主观成分,因此结果本来就侧重于平台所定立的标准,这跟一部分人的主观体验恰恰相反。

▲ DxOMark 选出 2019 年 5 款最佳拍照手机

这一点让我想起了最近被闹得沸沸扬扬的米其林评分,饮食专家有自己的一套评价标准,但每个人对饮食的要求、口味都不同,所以米其林的排名更多是一个参考指南,并不是它说好就绝对能符合大家的口味。

同理,诸如 DxOMark 、安兔兔、鲁大师这些跑分、评分平台,所得出的成绩只是基于平台标准,参考意义比决定意义更大。因此无论是平台的标准评分,还是大众参与的非标准评分,他们都只是给别人提供一个建议、一个基于自己标准的结果,而不是一个绝对值。

这也是为什么我会坚持在评测中加入‘结果仅供参考’这句话,因为每个人的使用情况、手机设置都不同,评测只是作为个人体验的参考报告。

▲ 续航测试本身就存在不定因素,每一台手机的使用情况、设置都不同,因此数据也只能作为参考

朋友 A 认为,iPhone 11 Pro Max 被 DxOMark 排到第三名是不公的表现,我问‘那你觉得 iPhone 拍照满意吗?’,他说‘个人觉得不比其他手机差’。

我说‘自己满意就行了,没必要因为排名而完全否认测试的可信度,你应该相信自己亲身体验的感觉,消费决策应该根据自己需求,而不是别人给出的几个数字。’

越是褒贬不一的东西,越应该亲自去找答案。